深度神经网络(DNN)是一种有多隐层的人工神经网络,这种神经网络即可进行有监督训练,也可进行无监督训练,结果出来的就是能够自行 “学习” 的机器学习(或者叫人工智能),也即所谓的深度学习。

前不久 Google DeepMind 在人机大战中击败李世石的 AI 围棋程序 AlphaGo 就采用了类似算法。AlphaGo 由一个搜索树算法和两个有数百万类神经元连接的多层深度神经网络组成。其中一个网络叫做 “策略网络”,用于计算走哪一步的胜率最高,另一个网络叫做 “价值网络”,用于告诉 AlphaGo 怎么移动对白子和黑子都更好,这样就可以降低可能性的深度。

由于前景看好,许多机器学习研究人员都已经把焦点集中到深度神经网络上面。但是,为了达到一定程度的智能,这些网络需要非常多的计算芯片,比如 AlphaGo 使用的计算芯片数量就达到了几千个。所以这是一项很耗计算资源、同时也很烧钱的任务。

目前限制人工智能发展的核心因素其中之一就是硬件。人脑有千亿神经元,百万亿突触构成的复杂网络,而现有芯片和这个还有多个数量级差距。为了推动人工智能发展,我国科学家本月初也发布了国际首个深度学习指令集DianNaoYu和首个深度学习处理器架构寒武纪。

不过现在 IBM 的研究人员又提出了一种新的芯片概念,IBM 的几位研究人员近日公布了一份论文(文章),论文阐述了一种所谓的电阻式处理单元(Resistive Processing Unit,RPU)的新型芯片概念,其强大的计算能力可以一个就顶传统芯片的几千,而如果将成千上万个这种芯片组合起来的话,未来 AI 的能力也许就会出现更多的突破。据称与传统 CPU 相比,这种芯片可以将深度神经网络的训练速度提高至原来的 30000 倍。

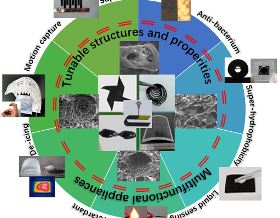

这种名为 RPU 的芯片主要利用了深度学习等算法的两个特点:本地性以及并行性。为此 ROU 借助了下一代非易失性内存(NVM)技术的概念,把算法用到的权重值存储在本地,从而把训练过程中的数据移动最小化。研究人员称,如果把这种 RPU 大规模应用到有 10 亿多个权重的深度神经网络,则训练速度最高可以加速 30000 倍,也就是说平时需要几千台机器训练几天才能出的结果用这种芯片几个小时就可以搞定,而且能效还要低得多。

当然,论文只是提出了一种概念,这种芯片目前还处在研究阶段,同时鉴于普通非易失性内存尚未进入主流市场,所以这样的芯片上市估计还需要几年的时间。不过如果这种芯片的确有那么大的计算和能效优势的话,相信 Google、Facebook 等从事 AI 研究和应用的巨头一定会关注的,而 IBM 本身也是 AI、大数据的积极参与者之一,东西要是做出来市场是应该不用发愁的。

文章链接:

Acceleration of Deep Neural Network Training with Resistive Cross-Point Devices

相关阅读:

(本文参考自36kr;由e科网整理修改)

如若转载,请注明e科网。

如果你有好文章想发表or科研成果想展示推广,可以联系我们或免费注册拥有自己的主页

- 人工智能

我要投稿

我要投稿

赞 3

赞 3

收起回复

收起回复